Klangfarbe

Drücke die Aufnahmetaste und summe oder singe eine einfache Melodie ohne Worte (z.B. „la-la-la“). Eine KI wandelt den Klang deiner Stimme in das ausgewählte Instrument um. (Anstatt zu singen, kannst du auch eine Flöte oder ein anderes Instrument spielen, das jeweils nur eine Note spielt).

Die Klangfarbe ist das Merkmal, das es uns ermöglicht, die gleiche Note mit der gleichen Lautstärke, gespielt auf zwei verschiedenen Instrumenten, zu unterscheiden.

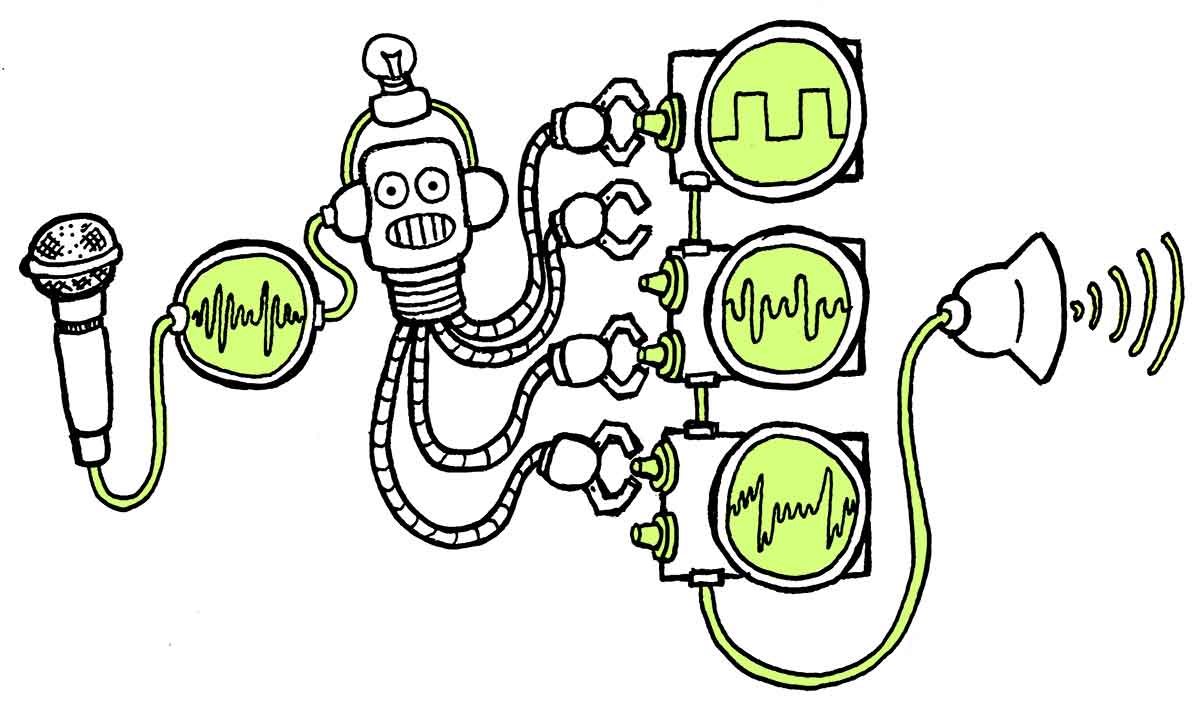

Die KI besteht aus zwei neuronalen Netzen. Das erste kodiert die Eingabe in Tonhöhe und Lautstärke und entfernt gewissermaßen die Klangfarbe. Das zweite ist ein Decoder, der mit vielen Stunden aufgezeichneter Musikaufführungen trainiert wurde. Er ist in der Lage, aus der Ausgabe des Encoders eine Klangdatei zu erstellen, die auf denselben Frequenzen und Lautstärken basiert, aber eine andere Klangfarbe aufweist. Wir verwenden für jedes Instrument einen anderen Decoder.

Die Aufteilung einer Eingabe in „Inhalt“ und „Stil“ und die anschließende Änderung des „Stil“-Teils ist eine häufige und neuartige Anwendung neuronaler Netze. Es gibt viele „Stiltransfer“-Apps, die ein beliebiges Bild im Stil eines berühmten Malers wiedergeben. Auch die Deepfake-Technologie funktioniert ähnlich, indem sie ein Gesicht in eine vereinfachte Darstellung kodiert und es mit einem Netzwerk dekodiert, das auf das Gesicht einer anderen Person trainiert wurde.

In diesem Kapitel werden wir

Erhellende Obertöne

Die Höhe eines Tons kann ziemlich genau durch eine Frequenz in Hertz beschrieben werden. Die Lautstärke kann in Dezibel gemessen werden. Aber die Klangfarbe zu beschreiben, ist komplexer. Wir beschreiben sie oft metaphorisch mit Begriffen wie hell, hohl, rund, scharf oder blechern (und noch vielen anderen Beschreibungen). Eine Geige und eine Trompete haben unterschiedliche Klangfarben, aber auch verschiedene Geigen können je nach Material oder Form unterschiedliche Timbres haben.

Eine andere Möglichkeit, sich die Klangfarbe vorzustellen, ist die „Form“ der Schallwelle. Die einfachste Schallwelle ist die Sinuswelle (wie sie von Oszillatoren in einem Synthesizer erzeugt wird), die durch ein gleichmäßiges Hin- und Herschwingen erzeugt wird. Bei akustischen Instrumenten ist die Physik jedoch komplexer. Eine schwingende Geigensaite beispielsweise folgt einer dreieckigen peitschenartigen Bewegung, die eine komplexere Welle erzeugt.

Die Art, wie wir die Saite zum Schwingen bringen, und die Art, wie sie am Instrument befestigt ist, erzeugt „Obertöne“, die man sich als zusätzliche Schwingungen in höheren Frequenzen vorstellen kann. Jedes Musikinstrument erzeugt eine Reihe von Obertönen mit unterschiedlichen Frequenzen, und diese Kombination verleiht dem Instrument seine Farbe. Auch die Bauweise des Instruments beeinflusst den Klang. Der Korpus einer Geige beispielsweise verstärkt bestimmte Obertöne und dämpft andere, je nach Größe, Form und Material des Instruments. Schließlich erkennen wir den Klang von Instrumenten auch daran, wie sich ihre Schallwellen im Laufe der Zeit verändern, z. B. hat ein Becken einen scharfen und lauten Anschlag, schwingt dann aber über einen längeren Zeitraum mit einer anderen Farbe nach.

Die Evolution der Sampler

Von Anfang an versuchte die elektronische Musik, die Klangfarbe akustischer Instrumente zu imitieren. Eine frühe Strategie bestand darin, mit Hilfe von Oszillatoren und Filtern eine Klangwelle mit denselben Obertönen wie bei akustischen Klängen zu erzeugen. Anschließend wurde eine „Hüllkurve“ eingesetzt, die die Lautstärke oder die Frequenzen mit der Zeit veränderte und so die Klangentwicklung eines physischen Instruments nachahmte.

Durch diese Technik entstand eine breite Palette von synthetischen Klangfarben. Dies sind die Klänge, die wir mit den 80er Jahren, mit elektronischer Musik und Retro-Videospielen assoziieren. Sie erinnern an die akustischen Instrumente, die sie inspiriert haben, aber sie klingen nicht realistisch.

Mit dem technologischen Fortschritt wurden diese synthetischen Klangfarben immer ausgereifter, aber sie standen im Wettlauf mit der Entwicklung einer alternativen Herangehensweise: der Arbeit mit Aufnahmen.

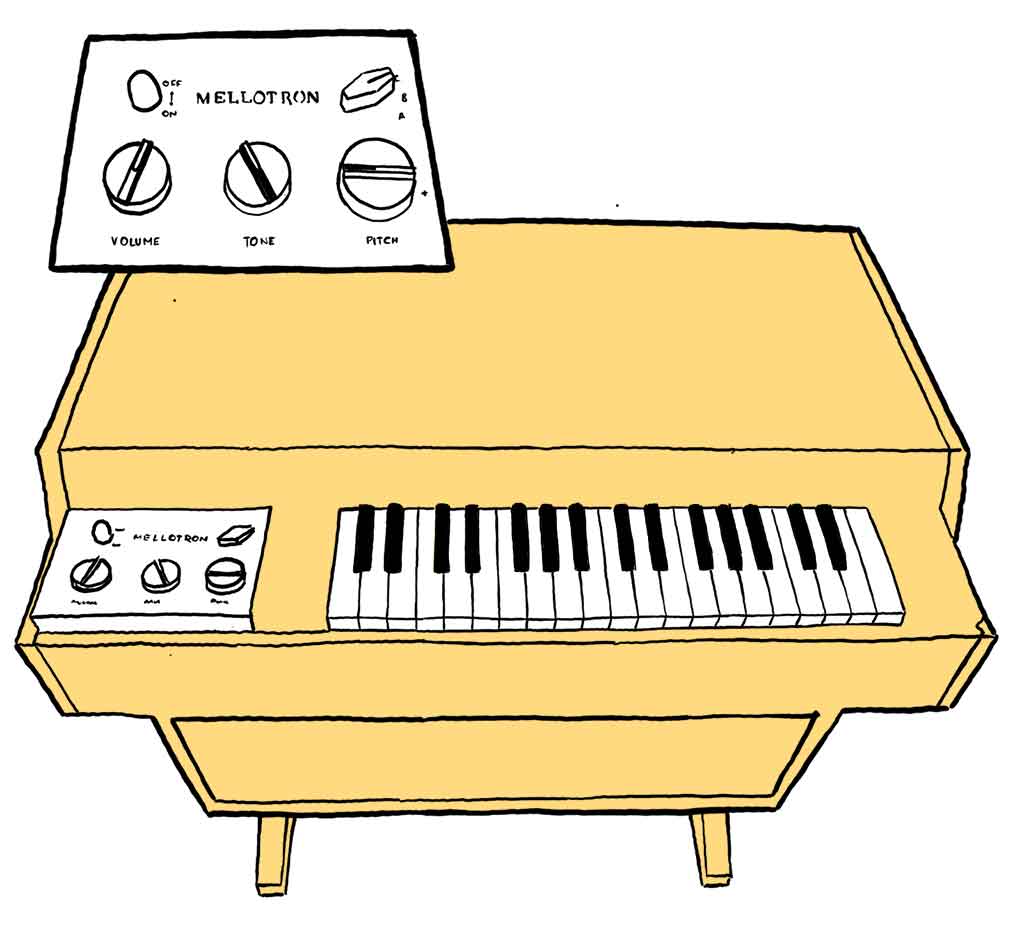

Das Mellotron ist ein ikonisches elektromechanisches Instrument. Es wird über eine klavierähnliche Tastatur gespielt. Wenn wir eine Taste drücken, beginnt ein Magnetband mit einem aufgezeichneten Ton zu spielen. Wenn wir die Taste loslassen, zieht eine Feder das Band in seine Ausgangsposition zurück. Die Bänder können gewechselt werden, um verschiedene Klänge abzuspielen. Außerdem kann die Geschwindigkeit der Bandwiedergabe geändert werden, um die Tonhöhe anzupassen.

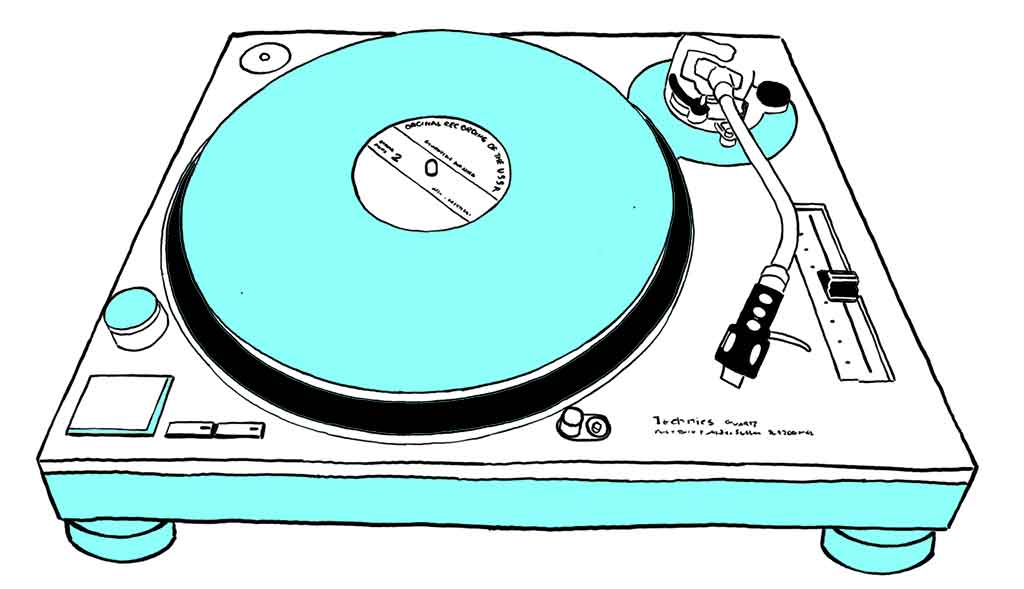

Die Verwendung von Plattenspielern als Musikinstrument geht bis in die 1930er Jahre zurück, aber Hip-Hop-Künstler*innen machten sie in den 1980ern erst so richtig populär. Sie entwickelten Techniken wie das Loopen von Songteilen, das Scratching und das Mischen des Schlagzeugs einer Platte mit dem melodischen Teil einer anderen. Soundcollagen, ebenfalls eine sehr frühe Technik, wurden zu einer Standardproduktionstechnik in der Popmusik.

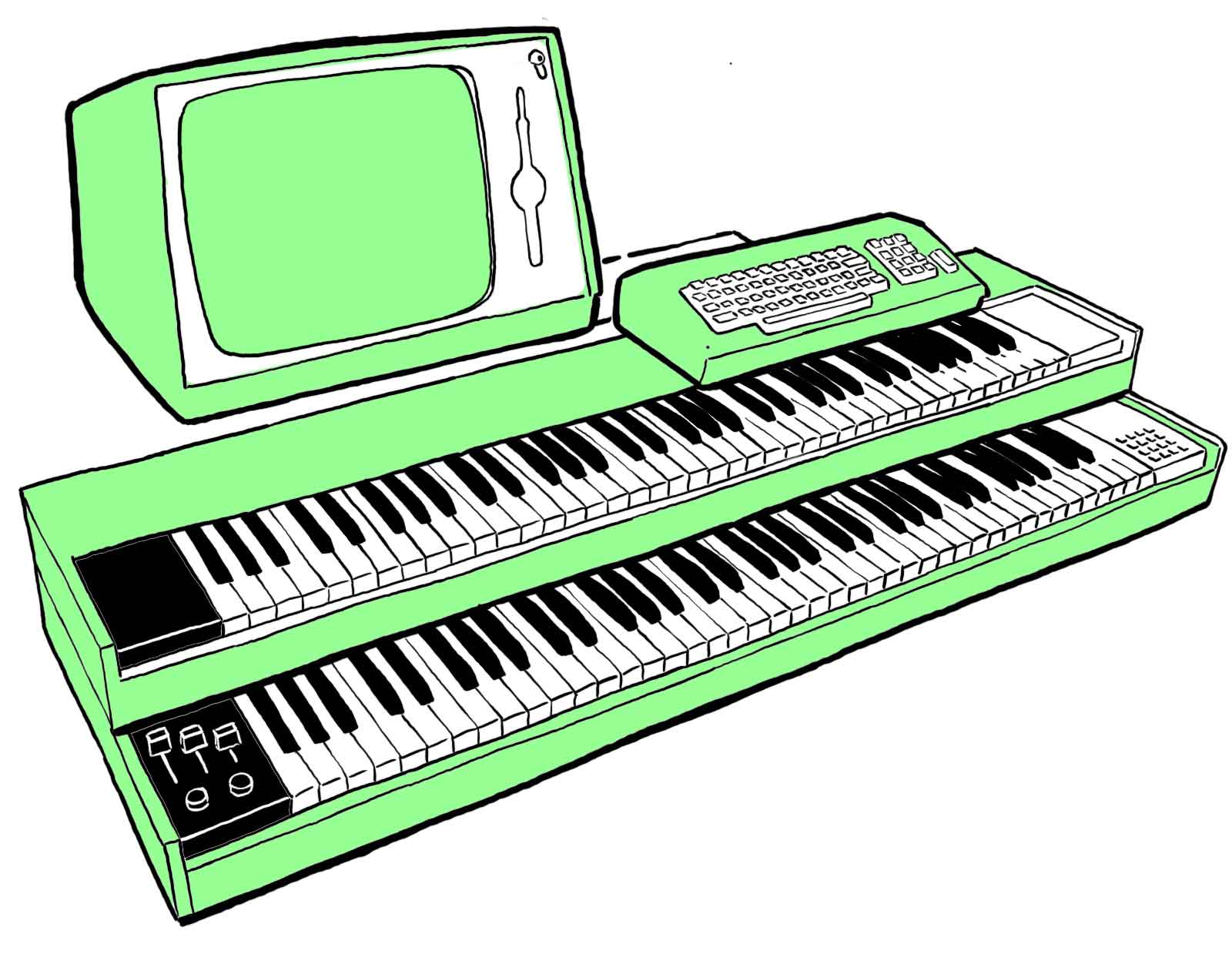

Der Fairlight CMI, der 1979 auf den Markt kam, war der erste kommerziell erhältliche polyphone digitale Sampler. Es war ein sehr teures System mit Synthesizer- und Digital-Audio-Workstation. Es verwendete Disketten zum Speichern von Samples in niedriger Qualität. Der Fairlight CMI versprach ein „Orchester in einer Box“, indem er acht Disketten mit jeweils 22 Samples von Orchesterinstrumenten enthielt.

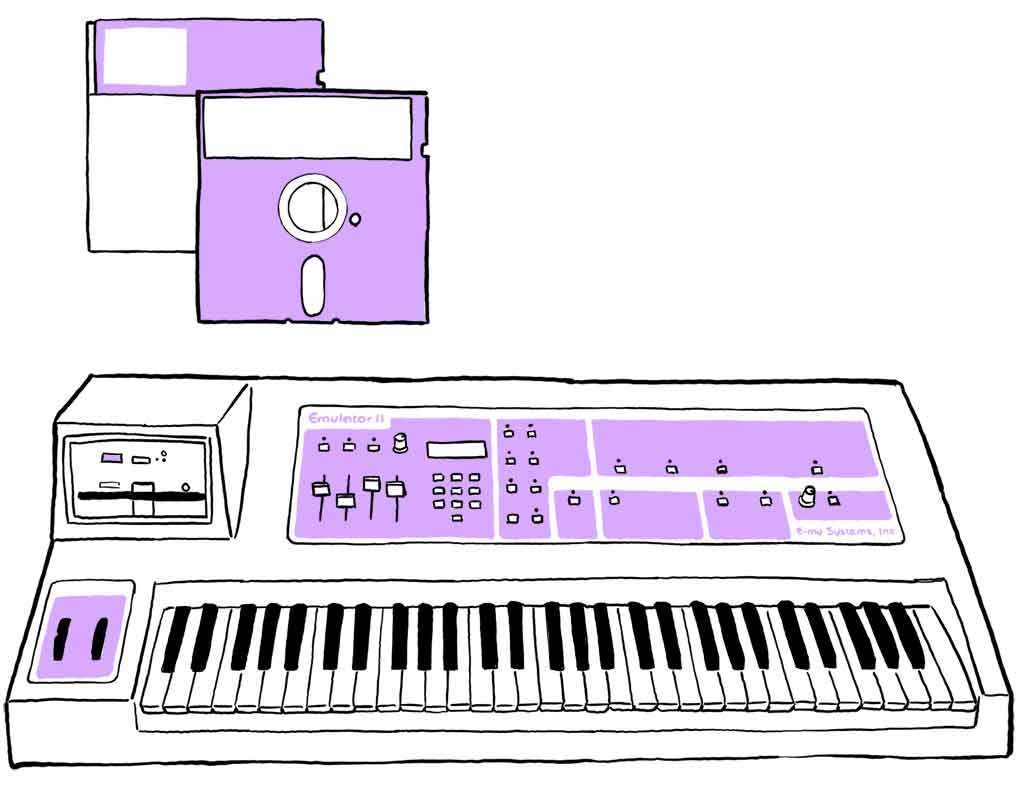

Der E-mu Emulator aus dem Jahr 1981 erfreute sich bei Musiker*innen großer Beliebtheit, da er preiswert und handlich war, so dass man ihn auch live einsetzen konnte. Seine zweite Version, die einige Jahre später veröffentlicht wurde, hatte eine bessere Klangqualität. Der E-mu Emulator wurde für viele Popaufnahmen und Filmmusiken jener Zeit verwendet, die eine breite Palette von Klängen hatten, wie z.B. die Shakuhachi-Flöte in Peter Gabriels „Sledgehammer“.

Moderne Sampler-Software kann viele Gigabytes an hochwertigen Aufnahmen eines Instruments enthalten, das jede Note auf unterschiedliche Weise spielt. Eine gängige Alternative sind virtuelle Instrumente, die mit Hilfe komplexer physikalischer Modelle simulieren, wie akustische Instrumente Klang erzeugen. Sie können unglaublich originalgetreu sein, hängen aber von der Fähigkeit ab, die Gesetze und physikalischen Prozesse zu erfassen, die die Klangerzeugung beeinflussen. Ein Vorteil des Einsatzes von KI für diese Aufgabe besteht darin, dass neuronale Netze lernen können, die Form der Schallwellen des Instruments, das wir imitieren wollen, einfach durch Training mit Beispielen zu reproduzieren, ohne dass wir ihnen physikalische Kenntnisse einprogrammieren müssen.

Wie funktioniert die KI?

Die neuronalen Netze in anderen Kapiteln (z. B. die über „Melodie“ oder „Rhythmus“) erzeugen Tonfolgen. Du kannst dir diese Sequenzen als Notenblätter oder MIDI-Dateien vorstellen. Diese Noten werden dann mit einem Synthesizer oder Sampler in deinem Browser abgespielt, um einen Sound zu erzeugen. Das neuronale Netz in diesem Kapitel macht etwas anderes.

Dieses neuronale Netz ist mit einer Reihe von DSP-Softwarekomponenten (Digital Signal Processors) verbunden, die wie herkömmliche Oszillatoren und Filter Schallwellen erzeugen und verändern können. Theoretisch könnte der Klang eines beliebigen Instruments (z. B. einer Trompete) reproduziert werden, indem eine Welle mit der richtigen Form erzeugt wird. In den Anfängen der elektronischen Musik wurden Oszillatoren und Filter von Menschen manuell bedient, was die Genauigkeit und Schnelligkeit, mit der Schallwellen geformt werden konnten, einschränkte.

Durch das Training mit Beispielen der Klangfarbe, die wir reproduzieren wollen, hat unser neuronales Netzwerk gelernt, die Parameter in den DSPs präzise zu steuern. Alle paar Millisekunden verändert das neuronale Netzwerk die Parameter der Oszillatoren, Filter, Rauschgeneratoren und des Halls, um die Klangwelle zu erzeugen, die du über deine Lautsprecher hören kannst. Du kannst dir das in etwa so vorstellen, als würdest du die verschiedenen Regler eines klassischen analogen Synthesizers, wie z. B. des Moog, mit übermenschlicher Geschwindigkeit bedienen.

Für jedes Instrument, dessen Klangfarbe wir reproduzieren wollen, verwenden wir ein anderes neuronales Netz. Diese Netze haben alle die gleiche Architektur, wurden aber mit unterschiedlichen Beispielen trainiert. Daher erzeugen sie eine unterschiedliche Ausgabe, selbst wenn sie dieselbe Eingabe erhalten.

Einige Punkte zum Nachdenken

Wir beschreiben Klangfarben durch Metaphern und Worte, die visuelle und taktile Informationen suggerieren, wie „rund“, „hohl“ oder „tief“.

Wie können wir KI nutzen, um neue Klangfarben zu schaffen, die zu den Gefühlen und Empfindungen passen, die wir ausdrücken wollen? Wie können wir der KI neben Worten noch andere Vorschläge machen, um einzigartige Klangfarben zu schaffen?

Externe Links

- Spiele mit der Vollversion von Google Magenta’s Tone Transfer, die zusätzliche Optionen, Beispiele und Erklärungen enthält.

- Hier ist der Quellcode in unserem Github-Repository.

Referenzen

Google Magenta’s Tone Transfer wurde vom Magenta- und AIUX-Team von Google Research entwickelt.

Die in dieser Demo verwendeten Modelle wurden durch Trainingsdaten ermöglicht, die von den folgenden Musiker*innen und Organisationen zur Verfügung gestellt wurden, angegeben wie bei Google:

Geige: Musopen (Creative Commons)

Flöte: Musopen (Creative Commons)

Trompete: University of Rochester

Saxophon: Kevin Malta

Copyright- und Lizenzinformationen sind in unserem GitHub-Repository.

Quellenangaben

- Jesse Engel, Lamtharn (Hanoi) Hantrakul, Chenjie Gu and Adam Roberts. DDSP: Differentiable Digital Signal Processing. International Conference on Learning Representations. 2020

- Gordon Reid. „Synthesizing Bowed Strings: The Violin Family.“ Synth Secrets. Sound on Sound magazine. 2003-04. Abgerufen am 2022-11-15.

- Wikipedia-Autoren. „Sampler (musical instrument).“ Wikipedia, The Free Encyclopedia. 2022-12-27. Abgerufen am 2022-12-28.

- Wikipedia-Autoren. „Mellotron.“ Wikipedia, The Free Encyclopedia. 2022-12-21. Abgerufen am 2022-12-22.

- Wikipedia-Autoren. „E-mu SP-1200.“ In Wikipedia, The Free Encyclopedia. 2022-12-09. Abgerufen am 2022-12-21.

Text is available under the Creative Commons Attribution License . Copyright © 2022 IMAGINARY gGmbH.